Nhận biết cảm xúc con người

Đã lâu rồi không có một bài viết về những gì mình đang làm. Thì là đây vậy. Sau khi hoàn thành, mình sẽ viết một phiên bản khác, đầy đủ hơn, dễ hiểu đối với mọi người.

Mình đang train thử model với mạng LittleVGG, chắc tới 7h sáng sẽ chạy xong, rồi test thử, xem nó không hiệu quả chỗ nào để thay đổi.

Trong lúc đấy mình vẫn còn nhiều thứ phải học, nên, nghe nhạc chút, tìm hiểu thêm chút, để lát đi ngủ là vừa.

Mình đang tìm hiểu về mấy cái thuật toán tối ưu, model đang chạy kia dùng rmspop, lát mình sẽ thử với adam, lại mất thêm 4 tiếng nữa.

Thế nhé, lát mình sẽ quay lại.

3:30: Sau nửa tiếng chạy 1 epochs thì train model đã lỗi gì đó.

3:33: Thì ra lỗi do mình viết nhầm địa chỉ save model, do nó không có quyền truy cập vào thư mục đó. Mình đoán là không thể lỗi được nữa, mình sẽ ngủ cho máy dồn toàn lực vào train model, sáng dậy sẽ xem thành quả, hy vọng không còn xảy ra lỗi gì.

6:55: Đã được 9/10 %.

12:40: Model lỗi khi lưu lại, mình đang cố sửa, có lẽ nó nằm ở layer softmax cuối cùng.

21:40: Hiện tại, model có tỉ lệ chính xác chỉ 40%, đồ thị có xu hướng giảm nhưng không rõ ràng.

2:13:

2:58: Còn nhiều thứ cần hoàn thiện trong project này quá. Nhưng ngủ thôi..

3:00: Bạn hay làm gì lúc ngủ, mỉm cười, cố gắng hạ nhịp độ của não bộ. Mình hay đọc vài trang sách (chắc vì thế mà chả bao giò đọc xong). Seneca thực sự rất hay, bạn nên đọc thử.

21:30: Ngày nay chưa làm được gì hơn cả, buổi chiều lỗi environment vào stackoverflow hàng giờ, bỗng nhiên nó sập, vừa đọc báo thì thấy do một cloud fastby gì đó lỗi nên nhiều trang cũng sập theo, CNN, TheVerge, Twitch,...

Cố gắng sửa lỗi để đi tập thể dục, nhưng không được, bật mình, đi mở nhạc cho quên đi, thì, spotify cũng sập ?

Mở trên youtube thì phải chọn từng bài, oài. Biết sao mình đang rảnh để viết không, vì cài lại môi trường đấy, lâu thật. Mỗi lần nó lỗi, là thời gian phí đi rất nhiều, lập trình là thế, mình chưa tìm thấy cách nào, để có thể tối ưu thời gian lỗi cả, tránh lỗi, là cả một bài dài.

2:30: Thú vị, nhưng mà khó.

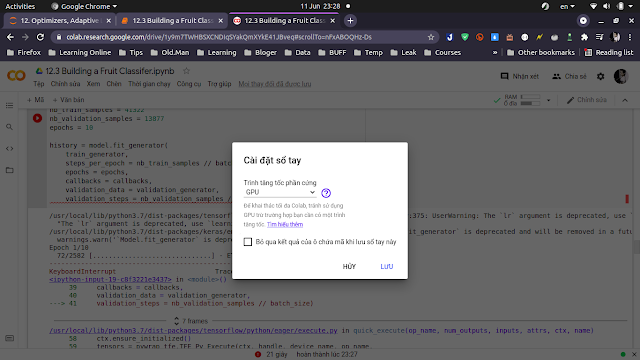

23:30: Nay đọc một số paper họ dùng macbook, ram 16G, chip M1 :D, mà còn không dám train model, nghĩ lại, có vẻ mình đã sai, nên mình quyết định dùng google colab, thường thường, mình mất 4 tiếng để train model này, thế mà, chỉ cần 10 phút, google colab đã chạy xong, quả là đáng ngưỡng mộ.

Mình nghĩ mình sẽ tiến bộ nhanh hơn với GPU miễn phí từ google. Chạy xong còn xem bóng đá chứ.

9:51 Sức mạnh

Mình đã tức tối với con em vì nó kể với mình là ở chỗ làm người ta bảo mua laptop đắt cho nó mới dùng được lâu dài, tức đến nỗi, nhắn lại nó: "ha ha ha", bởi vì, nghĩ, đơn giản thôi, đang là một sinh viên công nghệ thông tin, mình phải nghiên cứu rất nhiều, thực hành rất nhiều về công nghệ, nhẹ thì lập trình một trang web, rồi tạo máy chủ ảo, test trên máy mình, nặng hơn thì phải test api, có thể viết code để test, hoặc bằng postman, rồi đến lập trình di động, mình phải vừa tạo máy ảo là điện thoại, vừa code, rồi đến machine learning, máy tính của mình có hôm gõ lệnh top nó hiện, đã 30 ngày không tắt máy, mình chỉ nghĩ thầm, xin bạn, đừng chết.

Máy tính này là của chị mình, thực ra mình cũng có máy tính, nhưng mà mình thích dùng cái máy nho nhỏ thế này hơn, nó là một cái máy cũ, vì chị từng mua một cái máy mới nhưng mà bị lấy mất, vậy là, mình dùng máy cũ của cũ, thậm chí, mình còn chưa thay ssd, mới chỉ nâng RAM lên 12GB để học lập trình di động, mình thấy, vẫn ổn, ngỡ là, một con bé học kế toán, lại đòi máy xịn, mình không hiểu ?

Nhưng mà...

Cả buổi nay mình loay hoay tò mò xem có thể làm gì với google colab, biết có từ lâu lắm rồi nhưng chưa bao giờ hiểu kỹ hoặc cần đến sức mạnh của nó, google cho mình dùng một con Tesla T4, trị giá khoảng nửa trăm triệu đồng để thực hành.

Nếu bạn là một game thủ, chiếc máy tính mơ ước của bạn là bao nhiêu, nếu chỉ tính riêng card đồ họa đã là 50 triệu, mình đoán vậy là đủ nhỉ.

Vậy là, với sức mạnh đang có, mình bắt đầu nghĩ đến cách khai thác triệt để nó, như đào coin, làm server game, hoặc, sống trên đó luôn.

Với một chiếc card có thể xử lý 8 triệu tỉ ( 8 teraflop ) dấu chấm động mỗi giây, mình tin là có thể làm bất cứ điều gì, cách đây nhiều năm, nó thậm chí sẽ là một con siêu máy tính.

Tuyệt vời.

7:51, cả đêm qua tôi cứ suy nghĩ mãi về việc làm thế nào để cải thiện model, kỷ lục thế giới hiện tại tỉ lệ chính xác là 75%, tôi không ngủ được cứ mơ về con số 99 % trong đầu để rồi 6h sáng bật dậy tập thể dục không chịu được nằm nữa, tôi sẽ cố hết khả năng, ít nhất phải đạt được kỷ lục kia, tôi còn phải deploy nó nữa, thời gian cho project này không còn nhiều.

|

| Độ chính xác 45% |

Nãy do chất lượng ảnh nên không face detection được mấy ông ở đẳng sau.

22:10, hiện tại tỉ lệ chính xác của model trên tập test là 58%.

Confusion Matrix [[280 4 28 17 76 78 8] [ 11 38 1 1 1 2 1] [ 65 3 209 22 70 104 55] [ 21 0 9 766 37 24 22] [ 86 11 74 152 123 120 60] [ 46 1 44 28 145 322 8] [ 8 2 33 20 10 9 334]] Classification Report precision recall f1-score support Angry 0.54 0.57 0.56 491 Disgust 0.64 0.69 0.67 55 Fear 0.53 0.40 0.45 528 Happy 0.76 0.87 0.81 879 Neutral 0.27 0.20 0.23 626 Sad 0.49 0.54 0.51 594 Surprise 0.68 0.80 0.74 416 accuracy 0.58 3589 macro avg 0.56 0.58 0.57 3589 weighted avg 0.55 0.58 0.56 3589

Nhận xét

Đăng nhận xét